Haber Tarihi: 27 Ocak 2025 20:22 -

Güncelleme Tarihi:

27 Ocak 2025 20:22

DeepSeek Janus-Pro-7B nedir, nasıl kullanılır?

Çinli yapay zeka şirketi DeepSeek Pazartesi günü Janus Pro-7B olarak bilinen ikinci bir açık kaynaklı model yayınladı. Peki, DeepSeek Janus-Pro-7B nedir, nasıl kullanılır?

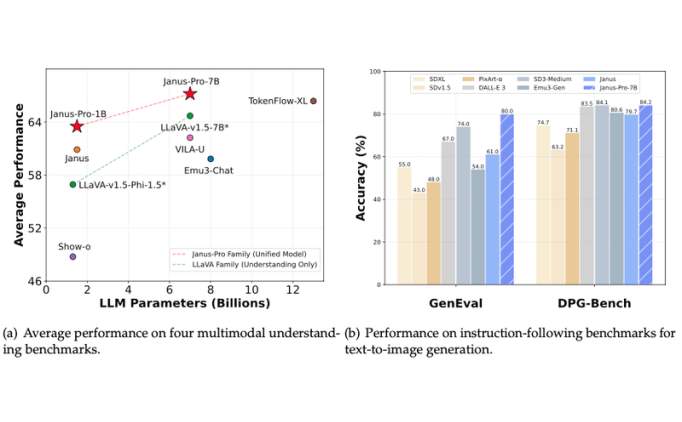

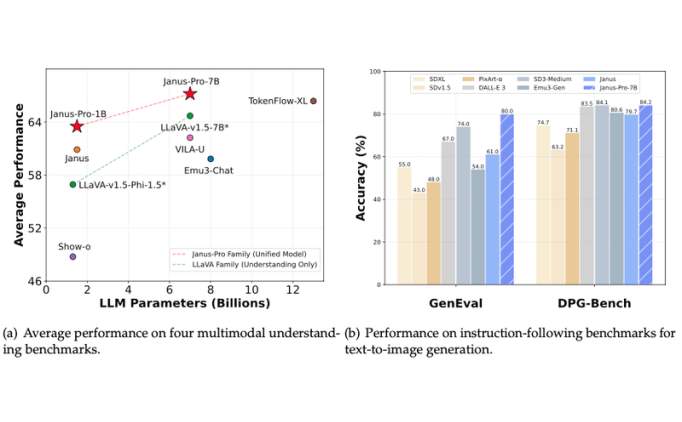

DeepSeek Janus-Pro-7B, gelişmiş bir Mixture-of-Experts (MoE) mimarisine sahip, açık kaynaklı bir yapay zeka modelidir. Çin merkezli DeepSeek şirketi tarafından geliştirilmiş olup, özellikle akıl yürütme, kodlama ve matematiksel görevlerde yüksek performans hedeflenerek tasarlanmıştır.

Temel Özellikleri:

MoE Mimarisi:Toplam ~7 milyar aktif parametre kullanır (toplam parametre sayısı daha yüksektir, ancak her işlemde yalnızca bir alt küme aktifleşir).Uzman alt ağlar (experts), görevlere özel verimlilik sağlar. Bu, modelin hem hızlı hem de kaynak açısından optimize olmasını sağlar.Yüksek Performans:HumanEval testinde %80.6 gibi etkileyici bir skorla kodlama becerilerini kanıtlamıştır.Matematiksel mantık (GSM8K) ve genel sorgularda (MMLU) da rakip modelleri geride bırakır.Açık Kaynak ve Erişilebilirlik:

Apache 2.0 lisansı altında yayınlanmıştır, ticari kullanıma izin verir.Hugging Face, GitHub gibi platformlarda erişilebilir.Verimlilik:Geleneksel yoğun (dense) modellere kıyasla, benzer performansı daha düşük hesaplama maliyetiyle sunar.Karşılaştırmalar:

DeepSeek-R1 gibi önceki modelleri performansla geride bırakır.GPT-3.5 ile karşılaştırılabilir sonuçlar üretir, ancak daha hafif bir yapıdadır.Kullanım Alanları:

Kod Üretimi: Yazılım geliştirme araçlarına entegrasyon.Veri Analizi: Karmaşık sorguların işlenmesi.Akıllı Asistanlar: Doğal dil anlama ve yanıt üretme.Eğitim: Matematik ve mantık problemlerinin çözümü.Sınırlamalar:

MoE mimarisi, yoğun modellere göre daha yüksek bellek gerektirebilir.İnce ayar ve dağıtım için teknik uzmanlık gerekebilir.DeepSeek Janus-Pro-7B, özellikle verimlilik ve uzmanlaşmış görevler için tasarlanmış, gelecek vaat eden bir modeldir. Geliştiriciler ve araştırmacılar, Hugging Face üzerinden model detaylarına ve kılavuzlara ulaşabilir. Haber ile daha fazlasına ulaşın:

Daha fazla göster

SON HABERLER

-

1

-

2

-

3

-

4

-

5

-

6

-

7

-

8

-

9

-

10

-

11

-

12

-

13

-

14

-

15

-

16

-

17

-

18

-

19

-

20

-

21

-

22

-

23

-

24

-

25

-

26

-

27

-

28

-

29

-

30

Sitemizden en iyi şekilde faydalanabilmeniz için

çerezler

kullanılmaktadır. Kişisel verileriniz, KKVK ve GDPR kapsamında toplanıp işlenmektedir. Detaylı bilgi almak

için

Veri Politikamızı / Aydınlatma Metnimizi inceleyebilirsiniz.

Sitemizi kullanarak çerez kullanımını kabul etmiş olacaksınız.